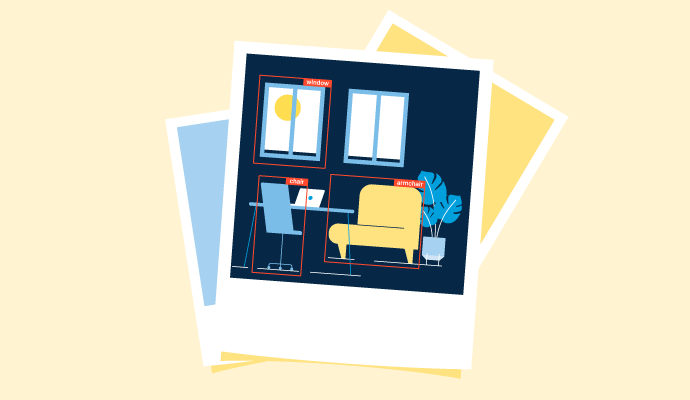

Objekterkennung hat ein neues Kapitel in der Computer Vision und Robotik eröffnet. Während einige Unternehmen Objekterkennung einsetzen, um Biometrie zu authentifizieren und Mitarbeiteranmeldedaten zu überprüfen, möchten andere intelligente Automatisierungsprodukte entwickeln. Die Verbesserung der Genauigkeit von Geräten mit Bildverarbeitungssoftware wird zu einem besseren Verbrauchererlebnis und Markenstabilität führen. Es gab schnelle Fortschritte in der Objekterkennung, da mehrere Branchen wie Automobil, Gesundheitswesen, E-Commerce und Einzelhandel auf KI-gestützte Software umsteigen. Besonders hervorzuheben sind Funktionen wie das Navigieren in überfüllten Bereichen, schnellere Dienstleistungen oder fahrerlose Transporte und medizinische Bildgebung, die einen größeren Einfluss auf die Menschheit haben können. Was ist Objekterkennung? Objekterkennung ist eine Computer Vision-Technik, die Elemente aus statischen oder dynamischen Bildern oder Videos lokalisiert, identifiziert und kategorisiert. Sie gewinnt an Bedeutung in Branchen, die Humanoide, künstliche Haustiere, Auto-Assistenzgeräte, Heimassistenten und Internet of Things (IoT)-Geräte einführen. Objekterkennung ist ein Teilbereich der künstlichen Intelligenz, der notwendige Informationen oder kritische Erkenntnisse aus einem Bild oder Video extrahiert. Sie zielt darauf ab, einem Computer zu helfen, ein vorhandenes Bild zu sehen und es in eine Reihe von Pixeln zu zerlegen, um ein bestimmtes Muster oder eine Form zu erkennen. Ein erfolgreicher KI-Objekterkennungsalgorithmus hängt von der Qualität der Daten ab, die zu seiner Schulung erforderlich sind. Mehr Daten bedeuten, dass das Modell Objekte schneller basierend auf bekannten Merkmalen klassifizieren kann. Objekterkennung ist ein menschlicher Denkprozess, um Objekte zu entschlüsseln und eine algorithmische Darstellung von Vektoren innerhalb der Objekte zu berechnen, um sie zu kategorisieren. Arten der Objekterkennung Objekterkennung kombiniert vier Techniken: Bildverarbeitung, Objektlokalisierung, Objekterkennung und Bildsegmentierung. Objekterkennung dekodiert die Merkmale und sagt die Kategorie oder Klasse des Bildes durch einen Klassifikator voraus, zum Beispiel überwachte maschinelle Lernmodelle wie Support Vector Machine (SVM), Adaboost, Boosting oder Entscheidungsbaum. Objekterkennungsalgorithmen sind in Darknet, einem Open-Source-Neuronalen Netzwerk-Framework, das in C, Cuda oder Python geschrieben ist, codiert. Hier sind einige wesentliche Arten der Objekterkennung: Bildverarbeitung Bildverarbeitung ist ein Vorgänger der Objekterkennung. Es ist eine kritische Phase im gesamten Prozess, die verwendet wird, um die Kategorie eines beliebigen Bildes vorherzusagen. Zum Beispiel, wenn Sie ein Bild eines Hundes im Park haben, analysiert das Bildverarbeitungssystem die Kerneigenschaften des Hundes: Gesicht, Gliedmaßen, Sehnen usw. und vergleicht es dann mit Tausenden von trainierten Bildern, um "Hund" als Ausgabe anzuzeigen. Objektlokalisierung Diese Technik wird verwendet, um den genauen Ort jedes Objekttyps in einem Bild zu lokalisieren. Wenn Sie ein Bild mit einem Hund und zwei Katzen eingeben, erstellt es eine Begrenzungsbox, die drei Dinge umschließt: einen Hund und zwei Katzen, um Standortkoordinaten, Höhe und Breite zusammen mit einer Klassenprognose zu lokalisieren. Einzelobjektlokalisierung identifiziert nur eine Instanz jedes Objekts und gibt deren Standort zurück. Im obigen Beispiel gibt die Einzelobjektlokalisierung den Wert eines Hundes und einer Katze zurück und eliminiert somit die redundante Komponente. Objekterkennung Das Objekterkennungssystem ist dem Objekterkennungssystem ähnlich. Das Ziel eines Objekterkennungssystems ist es, alle Vorkommen eines bestimmten Objekts oder einer Gruppe von Objekten in einem Bild zu identifizieren und zu klassifizieren. Bei der Objekterkennung erkennt das System automatisch das Vorhandensein eines Objekts und sagt dessen Klasse voraus. Bildsegmentierung Für die Bildsegmentierung wird ein neuronales Netzwerk oder ein maschineller Lernalgorithmus trainiert, um einzelne Objekte basierend auf Pixeln in einem Bild zu lokalisieren. Anstatt eine Grenze zu schaffen, analysiert es die Pixel des Objekts einzeln und hebt deren Standort hervor, um die Anwesenheit des Objekts festzustellen. Im Falle von teilweise verdeckten oder versteckten Objekten gibt das System keinen Wert zurück, da es keine beschatteten Gegenstücke des Bildes finden kann. Zum Beispiel, wenn es ein Autobild gibt, färbt das System das gesamte Auto rot, um es zusammen mit einer Klassenprognose "Auto" und einer Vertrauensbewertung "von 85%" hervorzuheben. Diese Ausgabe bestimmt, dass das System zu 85% sicher ist, dass das Objekt im Bild ein Auto ist. Objekterkennung vs. Objekterkennung vs. Bildsegmentierung Die Unterschiede zwischen diesen ähnlich klingenden Computer Vision-Techniken können verwirrend sein, insbesondere wenn alle eine ähnliche Aufgabe erfüllen. Objekterkennung ist ein allgemeiner Begriff, um eine Reihe von Computer Vision-Aufgaben zu beschreiben, die das Identifizieren von Komponenten einer realen Welt unter Verwendung der Objektmodellierung beinhalten. In der digitalen Bildverarbeitung wird die Objekterkennung verwendet, um greifbare und immaterielle Objekte zu klassifizieren, so wie es das menschliche Gehirn tut. Es verwendet eine Technik der "Merkmalsextraktion" und "Regionen-Pooling", um Komponenten zu gruppieren, die gemeinsame Merkmale haben, und es einem halbüberwachten Algorithmus zur Klassifizierung zuzuführen. Das Objekterkennungsmodell ist ein Vermittler zwischen dem System und dem Bild. Es hilft bei der Mehrklassenkategorisierung von Objekten zwischen verschiedenen dem Modell bekannten Datenklassen. Die Objekterkennung hilft, das Wesen einer Entität in jeder Form oder Gestalt zu bestimmen: gerade, krumm, verdeckt usw. Es ist in der Lage, mehrere Vorkommen einer einzelnen Entität zu identifizieren und so viele Begrenzungsboxen wie nötig zu erzeugen. Es kann den Bereich, das Volumen oder den Umfang des Objekts im Bild nicht extrapolieren. Bildsegmentierung ist eine Erweiterung der Objekterkennung. Diese Technik verwendet die Pixelierung eines bestimmten Bereichs des Objekts oder des gesamten Bildes. Es ist eine detailliertere Form der Objekterkennung, bei der das gesamte Bild gescannt und von Pixeln umrandet wird, die vom Computer interpretiert werden, um die relevante Kategorie zu finden. Es gibt zwei Arten von Bildsegmentierungsmethoden: Instanzsegmentierung: Identifizierung der Grenzen jeder Instanz eines Objekts und Darstellung mit verschiedenen Farben, die die richtige Klasse signalisieren. Semantische Segmentierung: Kennzeichnung jedes Pixels im Bild (einschließlich Hintergrund) und Einstellung von Beleuchtungskontrasten, um die Objekte voneinander zu unterscheiden. Objekterkennung vs. Bildverarbeitung Computer Vision ist eine geschichtete Technologie, bei der eine oder mehrere Aufgaben miteinander verschmelzen. Objekterkennung und Bildverarbeitung sind ein Beweis dafür. Beide Techniken haben in vielen Bereichen bemerkenswerte Meilensteine erreicht und bieten die gleichen Vorteile. Bildverarbeitung sagt die Klasse eines Bildes oder Videos als Ganzes voraus. Objekterkennung identifiziert mehrere Objekte in einem Bild oder Video mit definierten Labels. Es bündelt Bildklasse und beschreibende Ganzzahlen zusammen, um die Hauptausgabe anzuzeigen. Es bündelt Klasse, Standort, Häufigkeit und andere Faktoren von Objekten zusammen. Benutzer können einen QR-Code scannen, um digitale Inhalte auf einem Bild zu verankern. Benutzer können eine Kamera oder ein Smartphone schwenken, um reale Objekte in Echtzeit zu kennzeichnen. Eine Klassenliste wird in das Trainingsmodell eingespeist, um Bilder zu identifizieren. Leistungsstarke maschinelle Lernalgorithmen erkennen unbekannte Merkmale, um Objekte zu identifizieren. Das Modell wird auf dem K-nächste-Nachbarn-Algorithmus trainiert. Jedem Objekt wird eine Begrenzungsbox zugewiesen, die eine Vertrauensbewertung vorhersagt. In der Lieferkette wird es verwendet, um bestimmte Waren zu identifizieren und sie als defekt oder nicht defekt zu klassifizieren. Es hilft bei der Durchführung von Gesichtserkennung über Domänen hinweg, um Eindringlinge zu erkennen und das zuständige Team zu alarmieren. Wie funktioniert die Objekterkennung? Ein erfolgreicher Objekterkennungsalgorithmus hat zwei einflussreiche Faktoren: die Effizienz des Algorithmus und die Anzahl der Objekte oder Merkmale im Bild. Die Idee ist, das Bild mit dem maschinellen Lernalgorithmus abzugleichen und relevante Merkmale zu extrahieren, um die Objekte darin zu identifizieren und zu lokalisieren. Merkmale können entweder funktional oder geometrisch sein. Das Ergebnis ist immer entweder eine lineare oder eine binäre Klassenprognose – Ja oder Nein, je nachdem, welches Datenmodell Sie einsetzen. So funktioniert es: Merkmalsextraktion Merkmalsextraktoren sind die Operatoren, die ein Bild in verschiedene verzerrte Teile zerlegen und unbekannte Komponenten zur Klassifizierung extrahieren. Es wird hauptsächlich durch einen überwachten maschinellen Lernalgorithmus oder ein trainiertes konvolutionales neuronales Netzwerk (CNN) Modell wie Alexnet oder Inception erhalten. Der Algorithmus erstellt eine Merkmalskarte des Bildes, um die Identifizierung von Objekten zu erleichtern. Begrenzungsbox Jeder Teil des Bildes ist in einer Begrenzungsbox oder Ankerbox eingeschlossen. Die Begrenzungsbox ist statisch für ein Bild, aber dynamisch für die Identifizierung von Objekten in einem Video. Es ist eine rechteckige Grenze, die die Bewegung des Objekts oder seiner Merkmale für eine einfachere Klassifizierung einschränkt. Begrenzungsboxen können Informationen wie grafische Koordinaten, Wahrscheinlichkeitsbewertung, Höhe, Breite usw. zusammen mit 25 weiteren Datenelementen extrahieren. Hypothesenbildung Die Anzahl der extrahierten Bildmerkmale und die Qualität der Trainingsdaten, die dem Algorithmus zugeführt werden, sind kritische Elemente der Hypothesenbildung. Nach der Merkmalsextraktion generiert das System eine Wahrscheinlichkeitsbewertung und weist sie den im Bild vorhandenen Objekten zu. Dies wird hauptsächlich getan, um die Arbeitsbelastung eines maschinellen Lernklassifikators zu verringern. Das endgültige Ergebnis wird basierend auf der Wahrscheinlichkeitsbewertung und der Klassenprognose für jedes Objekt im Bild berechnet. Hypothesenüberprüfung An diesem Punkt wird die frühere Hypothese überprüft, was zu einer mittleren Klassifikationsbewertung führt, d.h. einer Metrik, die vom Algorithmus verwendet wird, um die Leistung der Klassenprognose verschiedener Objekte im Bild zu berechnen. Das eingesetzte KI-Modell überprüft relevante Merkmale des Objekts (Form, Größe, Farbe usw.) und die Klassenprognose durch die Begrenzungsbox, die das Objekt umschließt. Sobald beide Parameter überprüft sind, weist das System eine endgültige zusammengesetzte Bewertung zu. Erkennung und Zuordnung Sobald der Algorithmus die Merkmale klassifiziert, ordnet er die Koordinaten für die Begrenzungsbox dem Objekt zu. Diese Informationen werden in eine Support Vector Machine (SVM) eingespeist, die ein Frequent Pattern (FP) Wachstumstool verwendet, um die Klasse des Objekts in Echtzeit vorherzusagen. Die Koordinaten oder Achsen werden entweder horizontal oder vertikal analysiert, je nach Seitenverhältnis und Symmetrieebene. Lineare Regression Nach der Klassenprognose durchläuft das Bild eine lineare Regression, um den genauen Tensor (Container numerischer Daten, die vom Regressor des Objekts zurückgegeben werden) zu finden. Die Regression wird mit Open-Source-Plattformen wie Darknet, TensorFlow oder PyTorch durchgeführt. Das endgültige Ergebnis des Objekterkennungsalgorithmus umfasst die Kategorisierung der Objektklasse zusammen mit Details seiner Begrenzungsbox, um den genauen Standort des Objekts im Bild anzugeben. Wussten Sie schon? Der globale Markt für Bildverarbeitung wird von 26,2 Milliarden US-Dollar im Jahr 2020 auf 53,0 Milliarden US-Dollar im Jahr 2025 wachsen, mit einer durchschnittlichen jährlichen Wachstumsrate (CAGR) von 15,1 % von 2020 bis 2025! Quelle: MarketsandMarkets Objekterkennungsalgorithmen Der Ansatz zur Objekterkennung ist hauptsächlich zweigleisig – maschinelle Lernalgorithmen oder tiefenlernende konvolutionale neuronale Netzwerk (CNN) Modelle. Um eine Objekterkennungsaufgabe mit einem maschinellen Lernansatz durchzuführen, benötigen Sie einen Merkmalsextraktor, der zuvor unbekannte Objektinformationen identifiziert, um zwischen allgemeinen Labelkategorien zu unterscheiden. Auf der anderen Seite erfordert die Verwendung eines CNN-Netzwerks für die Objekterkennung keine manuelle Merkmalsextraktion oder Hypothesentests. Es kann Objekte und deren Standort direkt erkennen, indem es die Eigenschaften der Begrenzungsbox vorhersagt, die es umschließt. Lesen Sie weiter, um einige Standardalgorithmen zu entdecken, die zur Durchführung von Objekterkennungsaufgaben in verschiedenen Branchen verwendet werden können. Maschinelle Lernalgorithmen Maschinelles Lernen ist einer der beliebtesten Ansätze zur Überprüfung der Anwesenheit eines Objekts. Der maschinelle Lernalgorithmus ist ein prädiktives Analysedatenmodell, das auf zahlreichen Kategorien trainiert werden kann, d.h. Autos, Fahrräder, Berge usw. Mehrere überwachte und unüberwachte maschinelle Lernalgorithmen bieten viele Kombinationen von Merkmalsextraktoren und Modelldatensätzen, die Objekterkennungsaufgaben effizient und präzise ausführen. Schauen wir uns einige davon an: Viola-Jones-Algorithmus Der Viola-Jones-Algorithmus ist eines der bekanntesten Objekterkennungs-Frameworks. Sein Hauptziel ist es, dem System zu ermöglichen, menschliche Gesichter in einer geraden Konfiguration zu sehen, indem der folgende Prozess verwendet wird: Das Bild, das von einer Kamera oder einer Webcam aufgenommen wurde, wird verkleinert, um ein neues Bild zu erstellen. Merkmale wie Mund oder Nase und deren Beziehung zueinander werden manuell programmiert und dem neuen Bild hinzugefügt. Der Viola-Jones-Algorithmus läuft auf dem neuen Bild, um eine Reihe von Ausgabeelementen zu erstellen, die mit den vorhandenen Merkmalen des Objekts übereinstimmen. Die Ausgaben werden in eine Support Vector Machine eingespeist, um die Klasse der Objekte im Bild zu identifizieren, zum Beispiel das Gesicht. Kurz nach der Einführung wurde der Viola-Jones-Algorithmus in OpenCV implementiert und wurde als eine der erfolgreichsten Techniken zur Durchführung von Objekterkennung bekannt. Ein Problem, das jedoch auftrat, war, dass er Objekte mit teilweiser Verdeckung oder verzerrten Konfigurationen nicht identifizieren konnte. Tipp: Ein OpenCV-Klassifikator ist ein maschinelles Lernverfahren, das verwendet wird, um die Richtigkeit der Objektklasse durch eine Kaskadenfunktion zu überprüfen. OpenCV kann mit jedem maschinellen Lernobjekterkennungsalgorithmus verwendet werden. Histogramm der orientierten Gradienten Eine praktikablere Version des früheren Algorithmus, nämlich das Histogramm der orientierten Gradienten (HOGG), wurde 2005 veröffentlicht. HOGG war ein verbesserter maschineller Lernalgorithmus, der weit verbreitet in der Fußgängererkennung und Bildverarbeitung zur Objekterkennung eingesetzt wurde. So funktioniert es: Das System visualisierte ein gegebenes Bild als eine Reihe von Pixeln. Für jedes Pixel berechnete es, wie dunkel sein Gradient im Vergleich zum umgebenden Pixel war. Ein Pfeil wurde gezeichnet, der auf das dunklere Pixel zeigte. Dieser Prozess wiederholte sich, bis jedes einzelne Pixel ersetzt war. Eine Matrix von Pfeilen oder Gradienten trennte das Bild in kleine (16x16) Quadrate. Jedes Quadrat zeigte auf den Ort, an dem das Bild dunkel war. Pfeile, die das genaue Wesen des Objekts erfassten, ersetzten die Quadrate. Das System verglich die Ausgabe mit dem Originalbild unter Verwendung von Metriken wie der euklidischen oder Minkowski-Distanz. Basierend auf einem Schwellenwert bestimmte es, ob das gegebene Bild ein Objekt war oder nicht. HOGG wurde extrem populär, da es schnell zu berechnen war und ein viel stabileres Modell für den Objektklassifikator bot, um genau zu arbeiten. Skaleninvariante Merkmalsumwandlung Die skaleninvariante Merkmalsumwandlung (SIFT) ist ein beliebter Computer Vision-Algorithmus, der hilft, Objekte in digitalen Bildern durch Eckkanten zu identifizieren. Mehr wie eine Kantenerkennungstechnik identifiziert SIFT die gesamte Scanlinie eines Bildes und plottet grafisch spezifische Schlüsselpunkte mit einer logarithmischen Funktion. Sobald Merkmale lokalisiert sind, übergibt es diese quantitativen Informationen oder Deskriptoren an einen Klassifikator, um die Objekte zu kategorisieren und ihren spezifischen Standort im Bild zu finden. Bag-of-Features-Algorithmus Der "Bag-of-Features"- oder "Bag-of-Words"-Algorithmus analysiert zufällig verschiedene Merkmale eines Objekts, um seine Kategorie zu identifizieren. Basierend auf der sich entwickelnden Natural Language Processing (NLP)-Technologie ist es ein unüberwachter maschineller Lernalgorithmus, der reale Merkmale interpretiert, sie in einem Wörterbuch speichert und seinen Algorithmus verbessert, um bessere Ergebnisse zu erzielen. Tiefenlernen Die Ära des Tiefenlernens begann offiziell im Jahr 2012. Mit dem Aufstieg der Automobiltechnologie, der intelligenten Videoüberwachung und neuer API-Standards sind Objekterkennungsaufgaben relativ einfach geworden. Es gibt jedoch viel Arbeit, die mit der Lösung von Objekterkennungsproblemen durch Tiefenlernen verbunden ist, da es ausreichend grafische Verarbeitungseinheit (GPU)-Leistung und einen großen Trainingsdatensatz erfordert. Das CNN ist ein Tiefenlernmodell, das komplexe Computer Vision-Aufgaben durch künstliche Intelligenz löst. Das Modell selbst hat spezifische Eingabe- und Ausgabeschichten, die die Struktur des Gehirns nachahmen. Die Schichten dieses Modells repräsentieren natürlich vorkommende Axone, Dendriten, Pons und optische Fasern des Gehirns, die das menschliche Sehsystem antreiben. Hier sind einige tiefenlernende Algorithmen, die den Umfang der Computer Vision verbessert haben: Regionenbasiertes konvolutionales neuronales Netzwerk (R-CNN) Das regionenbasierte konvolutionale neuronale Netzwerk (R-CNN) ist ein leistungsstarkes selbsttrainiertes Modell, das auf dem VOC-2012-Datensatz und dem ILSVRC 2021-Datensatz arbeitet. Der ImageNet Large Scale Visual Recognition Challenge (ILSVRC) ist ein jährlicher akademischer Wettbewerb, der eine separate Herausforderung für Bildklassifikation, Objektlokalisierung und Objekterkennung bietet. Er wird mit der Absicht durchgeführt, unabhängige und separate Lösungen für jede Aufgabe zu fördern, die in größerem Maßstab implementiert werden können. Im Folgenden ist ein detaillierter Prozess der Bildverarbeitung durch R-CNN beschrieben. Zuerst muss der Benutzer eine Reihe von nicht kategorisierten Begrenzungsboxen für ein Bild oder "Kandidatenregionen" mit einem selektiven Suchalgorithmus generieren. Auf hoher Ebene betrachtet der selektive Suchprozess das Bild durch eine Reihe von Fenstern unterschiedlicher Größe. Jede Kandidatenregion gruppiert die Merkmale des Bildes wie Form, Farbe, Pixel, Intensität usw. Diese Merkmalskarten eines Bildes werden durch ein vortrainiertes CNN (Alexnet CNN) Modell geleitet, um Kernmerkmale zu extrahieren und die Ausgabeelemente zu berechnen. Sobald die Ausgabeelemente angezeigt werden, werden sie in einen SVM-Klassifikator eingespeist, um die Labels zu klassifizieren. Gleichzeitig werden die Begrenzungsboxen durch einen Regressor geleitet, um die Koordinaten der Objekte zusammen mit ihren Kategorien zu lokalisieren. Einschränkungen des R-CNN-Algorithmus Obwohl R-CNN sich als ein signifikant schnelleres Modell erwies, um ein Objekterkennungsmodell zu trainieren und Vorhersagen zu treffen, gab es immer noch einige Einschränkungen in seiner Funktionsweise. Hier ist eine Reihe von Einschränkungen für R-CNN, die es daran hinderten, genaue Ergebnisse zu liefern: Selektive Suche, Alexnet CNN und SVM-Klassifikator müssen alle auf einer Modelldatenbank trainiert und mit großen Mengen an grafischer Verarbeitungskraft betrieben werden. Das gleichzeitige Trainieren eines neuronalen Netzwerks auf mehr als 2000 Regionenvorschlägen war mühsam und zeitaufwendig. Das Modell kompilierte jede Kandidatenregion nacheinander sequentiell während des Tests. Da es das gesamte Bild nicht auf einmal scannte, waren die tatsächlichen Vorhersagen teilweise verdeckt und verschwommen. Wussten Sie schon? Effizientere Objekterkennungsmodelle wurden kürzlich vorgeschlagen, nämlich Fast R-CNN, Faster R-CNN und Mask R-CNN. Diese Algorithmen wurden auf großen Datensätzen wie VGG-16 und PASCAL VOC vortrainiert und liefern erstklassige Klassenprognosen. You Only Look Once (YOLO) Genau wie die Analogie von "you only live once" ist YOLO ein konvolutionales neuronales Netzwerk, das Daten einmal und für alle analysiert. Es wurde in den letzten Jahren eingeführt. Von allen Ansätzen zur Durchführung von Objekterkennungsaufgaben ist YOLO der genaueste. Es betrachtet ein Bild nur einmal, aber auf clevere Weise. Die Merkmalsextraktion eines Bildes oder Videos durch YOLO ist rückstandsfrei und völlig nahtlos. Es reduziert die Wahrscheinlichkeit, die das System einem Objekt zuweist, einer bestimmten Klasse anzugehören, um einen bestimmten Betrag, was zu einem stabileren Modell und einer genaueren Klassifizierung von Objekten führt. Hier ist eine standardisierte Übersicht darüber, wie YOLO funktioniert: Das Bild wird in ein Raster von 13*13 = 169 Zellen gleicher Dimensionen unterteilt. Jede Zelle des Bildes ist für die Vorhersage von bis zu 5 Begrenzungsboxen verantwortlich. An einem bestimmten Punkt überlappen sich Begrenzungsboxen mit Fragmenten von Objekten innerhalb der kleinen Zelle. Sobald es ein Objekt überlappt, weist es eine Vertrauensbewertung zu, die vorhersagt, ob die Begrenzungsbox ein Objekt erfasst hat oder nicht. Zusätzlich zur Vorhersage des Vorhandenseins der Begrenzungsbox weist das YOLO-Modell jeder Begrenzungsbox eine spezifische Klasse (z.B. Ampeln, Person, Auto usw.) zu. Insgesamt werden 169*5 oder 845 Begrenzungsboxen mit unterschiedlichen Vertrauensintervallen über das Bild verteilt. Das Vertrauensintervall wird mit der Klassenprognose des Objekts kombiniert. Basierend auf einer Schwellenzahl werden alle unnötigen Begrenzungsboxen eliminiert, und das Bild bleibt nur mit 2 bis 3 Boxen übrig, die das Objekt perfekt passen. YOLO-Implementierung für die Objekterkennung YOLO ist kein traditioneller Klassifikator. Das neuronale Netzwerk läuft einmal auf dem Bild. Jede Zelle im Bildraster hat einen spezifischen Tensorwert. In diesem Fall werden von jeder Zelle fünf Begrenzungsboxen vorhergesagt. Jede Begrenzungsbox ist verantwortlich für die Orchestrierung von 25 Datenelementen für das zugrunde liegende Objekt. Diese Elemente können Höhe, Breite, Boxkoordinaten (bx, by), Wahrscheinlichkeitsbewertung oder Vertrauensintervall umfassen. Daher wird der Tensorwert in diesem Fall 25*5 = 125 sein. Das YOLO-neuronale Netzwerk weist jedem Teil des Bildes einen Wahrscheinlichkeitswert zu, was es dem Erkenner erleichtert, die Anwesenheit von Objekten im Bild zu identifizieren und zu lokalisieren. Tipp: Die neueste Version von YOLO, YOLOv2 oder YOLO9000, ist ein einmaliger, Echtzeit-Objekterkennungs-CNN, das auf 9000 Objektklassen trainiert wurde und in eine .mp3- oder .mov-Datei eingebettet werden kann, um Begrenzungsboxen mit vorgegebenen Gewichten, Softmax-Klassifikator und Ankern vorherzusagen. Warum ist der YOLO-Algorithmus wichtig? Von allen bestehenden Ansätzen zur Computer Vision gibt YOLO einem Computer am besten die Fähigkeit zur Objekterkennung in realen Umgebungen und zur Interaktion mit ihnen, fast so gut wie Menschen. Da YOLO ein konvolutionales neuronales Netzwerk ist, erfordert es viel GPU und Trainingsdaten, um effizient zu arbeiten. Hier sind einige Gründe, warum YOLO der bevorzugte Objekterkennungsansatz in verschiedenen Geschäftsanwendungsbereichen ist: Es sagt Objekte in Bildern in Echtzeit voraus und läuft mit einer blitzschnellen Geschwindigkeit von 45 Bildern pro Sekunde (FPS). Es liefert genaue Ergebnisse bei der Erkennung von Objekten in Bildern. Im Laufe der Zeit lernt es, Formen und Muster in unbekannten Bildern selbst zu verstehen, um deren Kategorie zu klassifizieren. Neueste Techniken der Objekterkennung Die Implementierung einer einfachen Methode zur Objekterkennung anstelle von vernetzten künstlichen Intelligenzansätzen ist am besten. Ein direkter Weg zu Problemen verringert die kognitive Komplexität eines Problems. Es verhindert, dass das Systemmodell mehrere Bilder sammelt. Hier sind einige einfache Techniken der Objekterkennung, die Sie verwenden können, um Objekte innerhalb eines Bildes zu identifizieren: Vorlagenabgleich: Der Vorlagenabgleich ist eine Technik, bei der der Benutzer das Bild mit einer vorhandenen Vorlage vergleicht, die Ähnlichkeit der Merkmale abbildet und dem Bild ein Label zuweist. Mustererkennungsbasierte Objekterkennungssysteme arbeiten vollständig auf Vorlagenabgleichstechniken und erfordern keine Hypothesenbildung, um Objekte zu bestimmen. Visueller Transformer: Der visuelle Transformer verwendet eine Transformer-ähnliche Architektur über Patches eines Bildes. Das Bild wird in kleinere Patches unterteilt, die jeweils mit einem linearen Klassifikator auf einen Encoder projiziert werden. Das Ergebnis ist eine standardisierte Menge von Vektoren, die mit einem Klassifikationsknoten zusammentreffen, um die Anwesenheit von Objekten vorherzusagen. Ist Objekterkennung dasselbe wie Gesichtserkennung? Die Technik der Gesichtserkennung und der Objekterkennung sind zwei Seiten derselben Medaille. Gesichtserkennung ist eine neue Technologie, die automatisch gesichtsähnliche Strukturen innerhalb eines Bildes erkennt, um deren Identität zu bestimmen. In Echtzeit hilft die Gesichtserkennung, die nicht identifizierte Anwesenheit von Menschen oder verdächtigen Objekten in einem begrenzten Raum mit Hilfe von Kameras oder eingebetteten Geräten zu erkennen. Die Nutzbarkeit der Gesichtserkennung erstreckt sich über viele verschiedene industrielle Bereiche, wie Robotic Process Automation (RPA), Biometrieerkennung und Verteidigungsoperationen. Anwendungen der Objekterkennung Objekterkennung ist untrennbar mit vielen realen Anwendungen in verschiedenen Geschäftsfeldern verbunden. Mehrere Iterationen wurden durchgeführt, um die Objekterkennung für kommerzielle und nicht-kommerzielle Sektoren zu erstellen und zu verfeinern. Bisher waren Unternehmen ziemlich erfolgreich bei der Durchführung von Objekterkennung mit Narrow AI-Technologie. Hier sind einige reale Anwendungsbeispiele von Objekterkennungssystemen in verschiedenen Bereichen der Industrie: Sicherheit und Überwachung: Büros und Wohnkomplexe verwenden traditionelle CCTV-Kameras, die auf visuellen Objekterkennungsprinzipien basieren. Menschen verwenden jetzt sogar Sicherheitssysteme für ihre Haushaltsaktivitäten. Während eine Außenkamera Besucher beobachtet, helfen Innenkameras, die Aktionen eines Babys zu überwachen. Satelliten- und Erdabbildung: Objekterkennung hilft, Objekte in Luftbildern und atmosphärischem Druck zu erkennen. Es kann uns auch helfen, die Position von tektonischen Platten vorherzusagen, die sich aufgrund ständiger Metamorphose in unserem Kern bewegen. Die Unterstützung durch Radiofrequenzverteilung (RFID) ermöglicht es Piloten und Flugverkehrskontrolltürmen (ATC), kontinuierlich miteinander zu kommunizieren. Selbstfahrende Automobile: Objekterkennung ist ein entscheidender Bestandteil selbstfahrender Automobile. Die Fahrzeuge, die mit Objekterkennung ausgestattet sind, können sich frei bewegen, ohne dass jemand das Lenkrad kontrolliert. Um sicheres Fahren zu gewährleisten, müssen sie vollständig mit rechnerischer Sicht ausgestattet sein. Aktive Sensoren wie Lidar messen die Tiefe, Position und relative Entfernung von Objekten um die Fahrzeuge herum und identifizieren Straßensperren und Kollisionen. Tierüberwachung für Geflügel: Die Erkennung und Identifizierung von Nutztieren wie Schweinen oder anderen Viehbeständen auf mehreren Farmen ist jetzt mit KI-Vision-Algorithmen und kostengünstigen Überwachungskameras möglich. Im Vergleich zu anderen Methoden hilft KI-Vision, die Gesundheit und das Wohlbefinden von Tieren im Auge zu behalten. Dies führt zu einer verbesserten Produktqualität und Rentabilität von Tierprodukten. Erweiterte Mensch-Computer-Interaktion: Objekterkennung stellt einen Interaktionskanal zwischen Menschen und Computern in verschiedenen Anwendungsbereichen her. Es hilft, die bidirektionale Kommunikation zwischen zwei abhängigen oder unabhängigen intelligenten Genen zu verbessern und ermöglicht das genaue Senden und Empfangen von Signalen. Roboterstaubsauger: Objekterkennung ist der Standpunkt der Robotic Process Automation. Roboterstaubsauger wie Cyborgs und Roomba werden von KI-Technologie angetrieben, um Böden zu reinigen, ohne gegen etwas zu stoßen. Mit Hilfe einer eingebauten Kamera und eines 3D-Sensors erkennt der Roboter Objekte aus der Ferne, klassifiziert sie als Ablenkungen und wechselt in eine andere Richtung. Objekterkennung und erweiterte Realität Objekterkennung ist einer der entscheidenden Leistungsvektoren im Prozess der erweiterten Realität. Erweiterte Realität verbessert die Wahrnehmung der natürlichen Welt durch den Benutzer durch computergenerierte Bilder wie Grafiken, Text oder Geräusche. Mit Hilfe der Objekterkennung wird es ziemlich einfach, reale Elemente zu erkennen und zu manipulieren, um relevante visuelle Informationen zu übermitteln und hochgradig ansprechende Erlebnisse zu schaffen. Objekterkennung ist eine markerbasierte Technik, die hilft, eine Verbindung zu einem realen Objekt herzustellen und seine Position in Echtzeit zu verfolgen, um 3D-Animationen darüber zu legen. Mit anderen Worten, Objekterkennung lokalisiert kontrastreiche Punkte, Kurven oder Kanten von Objekten aus verschiedenen Blickwinkeln, um eine virtuelle Diashow vor unseren Augen zu erstellen. Das Geschenk des Sehens an Computer weitergeben Vor Jahren hätte niemand gedacht, dass künstliche Intelligenz nicht mehr als die "fünfte Generation von Computern" bekannt sein würde, sondern als aktueller Game-Changer für die Menschheit. Objekterkennung übergibt den Staffelstab des Sehens von Menschen an Computer. Sie hat das Potenzial, die moderne Geschäftswelt zu transformieren, indem sie hochmoderne, sichere Kundenerlebnisse gestaltet. Die Zukunft der Objekterkennung hängt auch von der Entwicklung der künstlichen Intelligenz-Technologie ab. Ähnlich wie die ursprüngliche industrielle Revolution wird sie in Zukunft die menschliche Arbeit reduzieren und den Menschen ermöglichen, das zu tun, wofür sie besser ausgestattet sind - kreativ und einfühlsam zu sein. Bewältigen Sie die Datenkennzeichnung wie ein Profi mit aktiven Lernwerkzeugen und senken Sie die KI-Infrastrukturkosten Ihrer Organisation, während Sie die höchste Genauigkeit beibehalten.

Möchten Sie mehr über Bildverarbeitungssoftware erfahren? Erkunden Sie Bilderkennung Produkte.

Shreya Mattoo

Shreya Mattoo is a Content Marketing Specialist at G2. She completed her Bachelor's in Computer Applications and is now pursuing Master's in Strategy and Leadership from Deakin University. She also holds an Advance Diploma in Business Analytics from NSDC. Her expertise lies in developing content around Augmented Reality, Virtual Reality, Artificial intelligence, Machine Learning, Peer Review Code, and Development Software. She wants to spread awareness for self-assist technologies in the tech community. When not working, she is either jamming out to rock music, reading crime fiction, or channeling her inner chef in the kitchen.