Qu'est-ce que la détection d'anomalies ?

La détection d'anomalies est une partie critique de l'exploration de données qui identifie les informations ou observations qui sont significativement différentes du schéma global de comportement du jeu de données.

Aussi connue sous le nom d'analyse des valeurs aberrantes, la détection d'anomalies trouve des erreurs comme des bugs techniques et identifie des changements qui pourraient résulter d'un comportement humain. Après avoir recueilli suffisamment de données pour former une base de référence, les anomalies ou les points de données qui dévient de la norme sont plus clairement visibles lorsqu'elles se produisent.

Être capable de trouver correctement des anomalies est essentiel dans de nombreuses industries. Bien que certaines anomalies puissent être des faux positifs, d'autres signifient un problème plus important.

Le piratage et la fraude bancaire sont quelques-unes des anomalies les plus couramment identifiées dans les données, où un comportement inhabituel est détecté à l'aide de logiciels de criminalistique numérique. Beaucoup de ces systèmes utilisent maintenant l'intelligence artificielle (IA) pour surveiller automatiquement les anomalies 24 heures sur 24.

Types de détection d'anomalies

Bien que chaque industrie ait son propre ensemble de données quantitatives uniques à ce qu'elles font, toute information évaluée pour la détection d'anomalies tombe dans l'une des deux catégories.

- Détection supervisée. Les données précédentes sont utilisées pour entraîner des machines gérées par l'IA à identifier les anomalies dans des jeux de données similaires. Cela signifie que la machine peut comprendre quels schémas attendre, mais cela peut causer des problèmes avec des anomalies qui n'ont pas été vues auparavant.

- Détection non supervisée. La plupart des entreprises n'ont pas assez de données pour entraîner avec précision les systèmes d'IA pour la détection d'anomalies. Au lieu de cela, elles utilisent des ensembles de données non étiquetés que la machine peut signaler lorsqu'elle croit que des valeurs aberrantes sont présentes sans les comparer à un jeu de données existant. Les équipes peuvent alors manuellement indiquer à la machine quel comportement est normal et lequel est une véritable anomalie. Au fil du temps, la machine apprend à les identifier par elle-même.

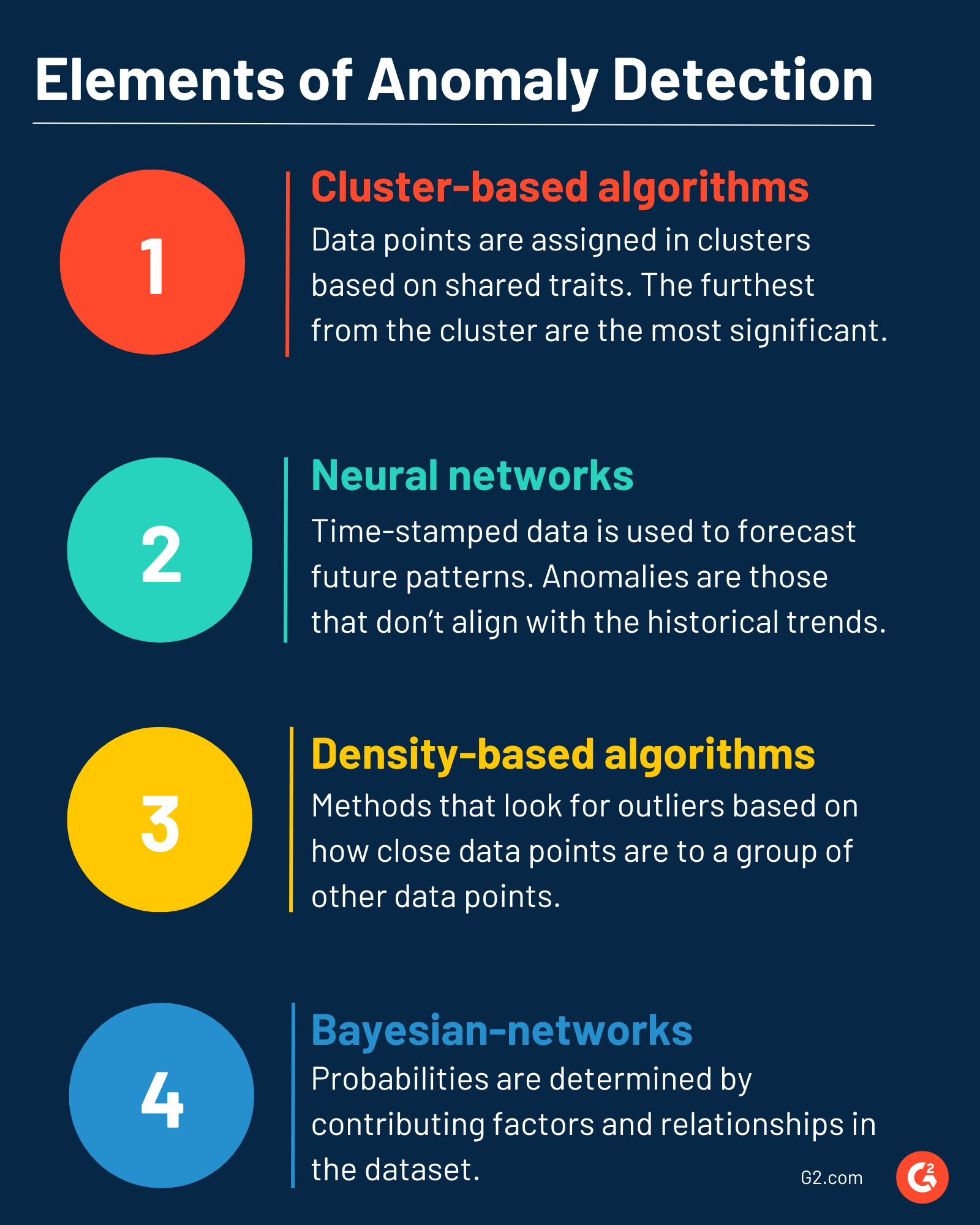

Éléments de base de la détection d'anomalies

Les techniques de détection utilisées pour trouver des anomalies seront déterminées par le type de données utilisées pour entraîner la machine, et l'organisation les rassemble continuellement.

Certaines des techniques les plus couramment utilisées sont :

- Algorithmes basés sur les clusters. Les points de données sont assignés dans des clusters sur un graphique en fonction de traits partagés. Tout ce qui ne s'intègre pas dans un cluster pourrait être une valeur aberrante, avec ceux plus éloignés du cluster plus susceptibles d'être une anomalie. Les points de données les plus éloignés du cluster sont les anomalies les plus significatives.

- Réseaux neuronaux. Les données horodatées prévoient les schémas futurs attendus ; les anomalies ne s'alignent pas avec les tendances historiques observées dans les données initiales. Les séquences et les points de déviation sont souvent utilisés dans ce type de détection.

- Algorithmes basés sur la densité. Comme les clusters, les méthodes de détection basées sur la densité recherchent des valeurs aberrantes en fonction de la proximité des points de données avec un groupe établi d'autres points de données. Les zones de plus haute densité indiquent plus de points de données, donc les anomalies en dehors de cela sont plus notables car elles sont séparées du groupe plus dense.

- Réseaux bayésiens. La prévision future est également importante dans cette technique. Les probabilités et les probabilités sont déterminées par des facteurs contributifs dans le jeu de données et en trouvant des relations entre les points de données ayant la même cause racine.

Avantages de la détection d'anomalies

Les entreprises fonctionnent maintenant avec des milliers de pièces de données différentes. Suivre ce niveau d'information manuellement est impossible, rendant la détection des erreurs plus difficile. C'est pourquoi la détection d'anomalies est utile, car elle peut :

- Prévenir les violations de données ou la fraude. Sans systèmes de détection automatisés, les valeurs aberrantes causées par des cybercriminels peuvent facilement passer inaperçues. Les systèmes de détection d'anomalies fonctionnent constamment, scannant pour tout ce qui est inhabituel et le signalant pour examen immédiatement.

- Découvrir de nouvelles opportunités. Toutes les anomalies ne sont pas mauvaises. Les valeurs aberrantes dans certains jeux de données peuvent indiquer des avenues de croissance potentielles, de nouveaux publics cibles ou d'autres stratégies d'amélioration des performances que les équipes peuvent utiliser pour améliorer leur retour sur investissement (ROI) et leurs ventes.

- Automatiser les rapports et l'analyse des résultats. En utilisant des méthodes de rapport traditionnelles, les anomalies peuvent prendre un temps considérable à trouver. Lorsque les entreprises essaient d'atteindre certains indicateurs clés de performance (KPI), ce temps peut être coûteux. L'automatisation de nombreux systèmes pour la détection d'anomalies signifie que les résultats peuvent être examinés beaucoup plus rapidement, de sorte que les problèmes peuvent être corrigés rapidement pour atteindre les objectifs commerciaux.

Meilleures pratiques pour la détection d'anomalies

Comme avec tout système automatisé, les résultats peuvent devenir accablants. Lors de la première mise en œuvre de la détection d'anomalies, il est conseillé de :

- Comprendre la technique la plus efficace pour le type de données évaluées. Avec tant de méthodologies, il est essentiel de sélectionner quelque chose qui fonctionne bien avec le type de données examinées. Recherchez cela à l'avance pour éviter les complications.

- Avoir une base de référence établie à partir de laquelle travailler. Même les entreprises saisonnières peuvent trouver un schéma moyen avec suffisamment de données. Savoir quels sont les schémas comportementaux normaux dans les données est le seul moyen de savoir quels points ne correspondent pas aux attentes et pourraient être des anomalies.

- Mettre en œuvre un plan pour traiter les faux positifs. Examiner manuellement les faux positifs possibles ou utiliser un ensemble de filtres peut empêcher les jeux de données biaisés et le temps perdu à poursuivre de fausses anomalies.

- Surveiller continuellement les systèmes pour les erreurs. La détection d'anomalies est un processus continu. Plus la machine utilise et apprend des données, plus elle devient intelligente et plus il est facile d'identifier les valeurs aberrantes. Un humain devrait encore effectuer des examens manuels périodiquement pour s'assurer que la machine apprend à partir d'informations précises et non à s'entraîner sur des jeux de données contenant des erreurs.

Protégez vos données d'entreprise 24/7 avec un logiciel de prévention des pertes de données (DLP) automatisé pour identifier les violations ou les fuites.

Holly Landis

Holly Landis is a freelance writer for G2. She also specializes in being a digital marketing consultant, focusing in on-page SEO, copy, and content writing. She works with SMEs and creative businesses that want to be more intentional with their digital strategies and grow organically on channels they own. As a Brit now living in the USA, you'll usually find her drinking copious amounts of tea in her cherished Anne Boleyn mug while watching endless reruns of Parks and Rec.