Supongamos que gestionas una librería en línea de gran tamaño. Siempre está abierta. Cada minuto o segundo, los clientes realizan y pagan pedidos. Tu sitio web tiene que ejecutar rápidamente numerosas transacciones utilizando datos modestos, como identificaciones de usuario, números de tarjetas de pago e información de pedidos.

Además de llevar a cabo las tareas diarias, también necesitas evaluar tu rendimiento. Por ejemplo, analizas las ventas de un libro o autor específico del mes anterior para decidir si pedir más para este mes. Esto implica recopilar datos transaccionales y transferirlos de una base de datos que soporta transacciones a otro sistema que gestiona grandes cantidades de datos. Y, como es común, los datos necesitan ser transformados antes de ser cargados en otro sistema de almacenamiento.

Solo después de estas acciones puedes examinar los datos con software dedicado. ¿Cómo mueves los datos, entonces? Si no sabes la respuesta, probablemente necesites una mejor infraestructura de software, como soluciones de intercambio de datos, herramientas de extracción, transformación y carga (ETL), o soluciones DataOps.

Probablemente necesites aprender lo que un pipeline de datos puede hacer por ti y tu negocio. Probablemente necesites seguir leyendo.

¿Qué es un pipeline de datos?

Un pipeline de datos es un proceso que implica la ingestión de datos en bruto de numerosas fuentes de datos y luego transferirlos a un repositorio de datos, como un lago de datos o un almacén de datos, para su análisis.

Un pipeline de datos es un conjunto de pasos para el procesamiento de datos. Si los datos aún necesitan ser importados a la plataforma de datos, se ingieren al inicio del pipeline. Sigue una sucesión de etapas, cada una produciendo una salida que sirve como entrada para el siguiente paso. Esto continúa hasta que se construye todo el pipeline. En algunos casos, los pasos independientes pueden coincidir.

Componentes del pipeline de datos

Antes de sumergirnos en el funcionamiento interno de los pipelines de datos, es esencial entender sus componentes.

- El origen es el punto de entrada para los datos de todas las fuentes de datos en el pipeline. La mayoría de los pipelines se originan en aplicaciones de procesamiento transaccional, interfaces de programación de aplicaciones (APIs), o sensores de dispositivos de Internet de las Cosas (IoT) o sistemas de almacenamiento como almacenes de datos o lagos de datos.

- El destino es el último lugar al que van los datos. El caso de uso determina el destino final.

- Flujo de datos es el transporte de datos desde la fuente hasta el destino y los cambios realizados en ellos. ETL es una de las metodologías de flujo de datos más utilizadas.

- Almacenamiento se refiere a los sistemas que mantienen los datos en varias etapas a medida que se mueven a través del pipeline.

- Procesamiento comprende todas las actividades y etapas involucradas en consumir, almacenar, cambiar y colocar datos. Aunque el procesamiento de datos está relacionado con el flujo de datos, esta etapa se centra en la implementación.

- Flujo de trabajo especifica una serie de procesos y sus dependencias entre sí.

- Monitoreo asegura que el pipeline y sus etapas funcionen correctamente y ejecuten las funciones necesarias.

- Tecnología se refiere a la infraestructura y herramientas que soportan la transmisión de datos, procesamiento, almacenamiento, flujo de trabajo y monitoreo.

¿Quieres aprender más sobre Herramientas ETL? Explora los productos de Herramientas ETL.

¿Cómo funciona el pipeline de datos?

Los datos generalmente se procesan antes de fluir hacia un repositorio. Esto comienza con la preparación de datos, donde los datos se limpian y enriquecen, seguido de la transformación de datos para filtrar, enmascarar y agregar datos para su integración y uniformidad. Esto es especialmente significativo cuando el destino final del conjunto de datos es una base de datos relacional. Las bases de datos relacionales tienen un esquema predefinido que debe alinearse para coincidir con las columnas y tipos de datos para actualizar los datos antiguos con los nuevos.

Imagina que estás recopilando información sobre cómo las personas interactúan con tu marca. Esto podría incluir su ubicación, dispositivo, grabaciones de sesiones, compras e historial de interacción con el servicio al cliente. Luego pones toda esta información en un almacén para crear un perfil para cada consumidor.

Como su nombre indica, los pipelines de datos sirven como el "tubo" para proyectos de ciencia de datos o paneles de inteligencia empresarial. Los datos provienen de diversas fuentes, incluidas APIs, lenguaje de consulta estructurado (SQL) o bases de datos NoSQL; sin embargo, no siempre son adecuados para su uso instantáneo.

Los científicos o ingenieros de datos generalmente realizan tareas de preparación de datos. Formatean los datos para cumplir con los requisitos del caso de uso empresarial. Una combinación de análisis exploratorio de datos y necesidades empresariales establecidas a menudo decide el tipo de procesamiento de datos que requiere un pipeline. Los datos pueden mantenerse y mostrarse cuando se filtran, combinan y resumen correctamente.

Los pipelines de datos bien organizados son la base para diversas iniciativas, incluido el análisis exploratorio de datos, la visualización y las actividades de aprendizaje automático (ML).

Tipos de pipelines de datos

El procesamiento por lotes y el streaming de datos en tiempo real son los dos tipos básicos de pipelines de datos.

Procesamiento por lotes de datos

Como indica el nombre, el procesamiento por lotes carga "lotes" de datos en un repositorio a intervalos predeterminados, a menudo planificados durante las horas no pico de negocio. Otros trabajos no se ven afectados ya que los trabajos de procesamiento por lotes generalmente operan con grandes cantidades de datos, lo que podría sobrecargar todo el sistema. Cuando no hay una necesidad urgente de examinar un conjunto de datos específico (por ejemplo, contabilidad mensual), el procesamiento por lotes es el mejor pipeline de datos. Está asociado con el proceso de integración de datos ETL.

ETL tiene tres etapas:

- Extraer: obtener datos en bruto de una fuente, como una base de datos, un archivo XML o una plataforma en la nube que contiene datos para herramientas de marketing, sistemas CRM o sistemas transaccionales.

- Transformar: cambiar el formato o estructura del conjunto de datos para que coincida con el sistema de destino.

- Cargar: transferir el conjunto de datos al sistema de destino, que podría ser una aplicación o una base de datos, un data lakehouse, un lago de datos o un almacén de datos.

Streaming de datos en tiempo real

A diferencia del procesamiento por lotes, el streaming de datos en tiempo real denota que los datos necesitan actualizarse continuamente. Las aplicaciones y los sistemas de punto de venta (PoS), por ejemplo, requieren datos en tiempo real para actualizar el inventario de sus artículos y el historial de ventas; esto permite a los comerciantes notificar a los consumidores si un producto está en stock. Una sola acción, como la venta de un producto, se denomina "evento", y los eventos relacionados, como agregar un artículo al carrito de compras, generalmente se agrupan como un "tema" o "flujo". Estos eventos se enrutan posteriormente a través de sistemas de mensajería o brokers de mensajes, como Apache Kafka, un producto de código abierto.

Los pipelines de datos en streaming ofrecen una latencia más baja que los sistemas por lotes porque los eventos de datos se manejan inmediatamente después de que ocurren. Sin embargo, son menos confiables que los sistemas por lotes, ya que los mensajes podrían perderse inadvertidamente o pasar mucho tiempo en la cola. Los brokers de mensajes ayudan a abordar este problema con reconocimientos, lo que significa que un consumidor verifica el procesamiento del mensaje al broker para que pueda ser eliminado de la cola.

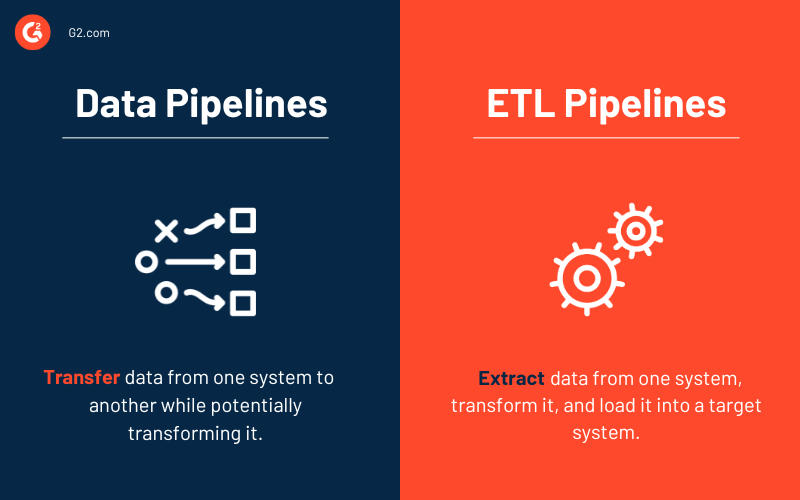

Pipelines de datos vs. pipelines ETL

Algunas palabras, como pipeline de datos y pipeline ETL, pueden usarse indistintamente. Sin embargo, considera un pipeline ETL como un subtipo del pipeline de datos. Tres características fundamentales separan los dos tipos de pipelines.

- Los pipelines ETL siguen un orden predeterminado. Como sugiere el acrónimo, extraen, convierten, cargan y almacenan datos en un repositorio. Este orden no es necesario para todos los pipelines de datos. De hecho, el surgimiento de soluciones nativas de la nube ha aumentado el uso de pipelines ETL. La ingesta de datos aún viene primero con este tipo de pipeline, pero cualquier transformación viene después de que los datos se han cargado en el almacén de datos en la nube.

- Aunque el alcance de los pipelines de datos es mayor, los pipelines ETL frecuentemente involucran procesamiento por lotes. También podrían incluir procesamiento en flujo.

- Finalmente, a diferencia de los pipelines ETL, los pipelines de datos en su conjunto no siempre necesitan transformaciones de datos. Casi todos los pipelines de datos utilizan transformaciones para facilitar el análisis.

Arquitectura del pipeline de datos

El diseño de un pipeline de datos comprende tres fases clave.

- Ingesta de datos. Los datos se adquieren de muchas fuentes, incluidos datos estructurados y no estructurados. Estas fuentes de datos en bruto se denominan comúnmente productores, publicadores o emisores en el contexto de datos en streaming. Mientras que las organizaciones podrían optar por extraer datos solo cuando estén listas para analizarlos, es mejor primero aterrizar los datos en bruto en un proveedor de almacén de datos en la nube. Esto permite a la empresa enmendar cualquier dato pasado si necesitan cambiar las operaciones de procesamiento de datos.

- Transformación de datos. Durante esta etapa, se realizan una serie de tareas para convertir los datos en el formato requerido por el repositorio de datos de destino. Estas tareas incorporan automatización y gobernanza para flujos de trabajo repetidos, como informes empresariales, asegurando que los datos se limpien y conviertan constantemente. Un flujo de datos, por ejemplo, puede estar en formato de notación de objetos de JavaScript (JSON) en capas, y el paso de transformación de datos intentará desenrollar ese JSON para extraer los campos esenciales para el análisis.

- Repositorio de datos. Los datos transformados se almacenan posteriormente en un repositorio y se ponen a disposición de múltiples partes interesadas. Los datos alterados a veces se denominan consumidores, suscriptores o receptores.

Beneficios de los pipelines de datos

Las empresas tienden a aprender sobre los pipelines de datos y cómo ayudan a las empresas a ahorrar tiempo y mantener sus datos estructurados cuando están creciendo o buscando mejores soluciones. A continuación se presentan algunas ventajas de los pipelines de datos que las empresas podrían encontrar atractivas.

- Calidad de los datos se refiere a la facilidad con la que los usuarios finales pueden monitorear y acceder a datos relevantes a medida que se mueven de la fuente al destino.

- Los pipelines permiten a los usuarios generar flujos de datos de manera iterativa. Puedes tomar una pequeña porción de datos de la fuente de datos y presentarla al usuario.

- Replicabilidad de patrones puede reutilizarse y repropósito para nuevos flujos de datos. Son una red de pipelines que genera un método de pensamiento en el que los pipelines individuales se ven como ejemplos de patrones en un diseño más amplio.

Desafíos con los pipelines de datos

Construir un pipeline de datos bien arquitectado y de alto rendimiento requiere planificar y diseñar múltiples aspectos del almacenamiento de datos, como la estructura de datos, el diseño del esquema, el manejo de cambios en el esquema, la optimización del almacenamiento y el escalado rápido para satisfacer aumentos inesperados en el volumen de datos de la aplicación. Esto a menudo requiere el uso de una técnica ETL para organizar la transformación de datos en muchas fases. También debes garantizar que los datos ingeridos se verifiquen para la calidad o pérdida de datos y que las fallas de trabajo y excepciones se monitoreen.

A continuación se presentan algunos de los problemas más comunes que surgen al trabajar con pipelines de datos.

- Aumento en el volumen de datos procesados

- Cambios en la estructura de los datos de origen

- Datos de mala calidad

- Insuficiente integridad de los datos en los datos de origen

- Duplicación de datos

- Retraso de archivos de datos de origen

- Falta de una interfaz de desarrollador para pruebas

Casos de uso de pipelines de datos

La gestión de datos se está convirtiendo en una preocupación cada vez más importante a medida que los datos extensos crecen. Si bien los pipelines de datos sirven para diversos propósitos, los siguientes son tres aplicaciones comerciales principales.

- Análisis exploratorio de datos (EDA) evalúa e investiga conjuntos de datos e informa sobre sus propiedades principales, generalmente utilizando enfoques de visualización de datos. Ayuda a determinar cómo modificar las fuentes de datos para obtener las respuestas necesarias, haciendo más sencillo para los científicos de datos descubrir patrones, detectar anomalías, probar hipótesis y validar suposiciones.

- Visualizaciones de datos utilizan visuales populares para describir datos: gráficos, diagramas, infografías y animaciones. Estos visuales de información explican relaciones de datos complejas e ideas impulsadas por datos de una manera fácil de entender.

- El aprendizaje automático es un subcampo de la inteligencia artificial (IA) y la informática que utiliza datos y algoritmos para imitar cómo aprenden las personas, mejorando gradualmente su precisión. Los algoritmos se enseñan para generar clasificaciones o predicciones utilizando enfoques estadísticos, revelando ideas cruciales en iniciativas de minería de datos.

Ejemplos reales de pipelines de datos

A continuación se presentan algunos ejemplos de pipelines de datos en la vida real de empresas que han creado pipelines modernos para su aplicación.

- Uber necesita datos en tiempo real para implementar precios dinámicos, calcular el tiempo de llegada más probable y anticipar la demanda y la oferta. Despliegan pipelines de streaming que ingieren datos actuales de aplicaciones de conductores y pasajeros utilizando tecnologías como Apache Flink. Estos datos en tiempo real se incorporan a algoritmos de aprendizaje automático, que proporcionan pronósticos minuto a minuto.

- Hewlett Packard Enterprise esperaba mejorar la experiencia del cliente con su capacidad de mantenimiento predictivo. Construyeron un pipeline de datos eficiente con motores de streaming como Akka Streams, Apache Spark y Apache Kafka.

- Dollar Shave Club requería datos en tiempo real para interactuar con cada consumidor por separado. Después de alimentar información en su sistema de recomendación, el programa elegía qué productos promover para su inclusión en un correo electrónico mensual dirigido a clientes individuales. Crearon un pipeline de datos automatizado utilizando Apache Spark para esta práctica.

Mejores prácticas para pipelines de datos

Puedes evitar los peligros significativos de pipelines de datos mal construidos siguiendo las prácticas recomendadas que se describen a continuación.

- Solución de problemas simple: Al eliminar dependencias innecesarias entre los componentes del pipeline de datos, solo tienes que rastrear hasta el sitio de falla. Simplificar las cosas mejora la previsibilidad del pipeline de datos.

- Escalabilidad: A medida que las cargas de trabajo y los volúmenes de datos crecen exponencialmente, un diseño ideal de pipeline de datos debería poder escalar y expandirse.

- Visibilidad de extremo a extremo: Puedes asegurar consistencia y seguridad proactiva con monitoreo continuo e inspecciones de calidad.

- Pruebas: Después de ajustar en base a las pruebas de calidad, ahora tienes un conjunto de datos confiable para ejecutar a través del pipeline. Después de definir un conjunto de pruebas, puedes ejecutarlo en un entorno de pruebas separado; luego compararlo con la versión de producción de tu pipeline de datos y la nueva versión.

- Mantenibilidad: Procedimientos repetibles y adherencia rigurosa a los protocolos apoyan un pipeline de datos a largo plazo.

Herramientas de pipeline de datos

Las herramientas de pipeline de datos soportan el flujo de datos, almacenamiento, procesamiento, flujo de trabajo y monitoreo. Muchos factores influyen en su selección, incluido el tamaño del negocio y la industria, las cantidades de datos, los casos de uso de datos, el presupuesto y las necesidades de seguridad.

Los siguientes son grupos de soluciones comúnmente utilizados para construir pipelines de datos.

Herramientas ETL

Las herramientas ETL incluyen soluciones de preparación de datos e integración de datos. Se utilizan principalmente para mover datos entre bases de datos. También replican datos, que luego se almacenan en sistemas de gestión de bases de datos y almacenes de datos.

Las 5 mejores herramientas ETL:

* Arriba están las cinco principales soluciones ETL del Informe Grid® de Verano 2023 de G2.

Plataformas DataOps

Las plataformas DataOps orquestan personas, procesos y tecnología para entregar un pipeline de datos confiable a sus usuarios. Estos sistemas integran todos los aspectos de la creación y operaciones del proceso de datos.

Las 5 mejores plataformas DataOps:

* Arriba están las cinco principales soluciones DataOps del Informe Grid® de Verano 2023 de G2.

Soluciones de intercambio de datos

Las empresas utilizan herramientas de intercambio de datos durante la adquisición para enviar, adquirir o enriquecer datos sin alterar su propósito principal. Los datos se transfieren de manera que puedan ser fácilmente ingeridos por un sistema receptor, a menudo normalizándolos completamente.

41.8%

de las pequeñas empresas en la industria de TI utilizan soluciones de intercambio de datos.

Fuente: datos de reseñas de clientes de G2

Varias soluciones de datos pueden trabajar con intercambios de datos, incluyendo plataformas de gestión de datos (DMPs), software de mapeo de datos al mover datos adquiridos al almacenamiento, y software de visualización de datos para convertir datos en paneles y gráficos legibles.

Las 5 mejores herramientas de software de intercambio de datos:

* Arriba están las cinco principales soluciones de intercambio de datos del Informe Grid® de Verano 2023 de G2.

Otros grupos de soluciones para pipelines de datos incluyen lo siguiente.

- Almacenes de datos son repositorios centrales para almacenar datos convertidos para un propósito específico. Todas las principales soluciones de almacén de datos ahora transmiten la carga de datos y permiten operaciones ETL y de transmisor de localización de emergencia (ELT).

- Los usuarios almacenan datos en bruto en lagos de datos hasta que los necesiten para análisis de datos. Las empresas desarrollan pipelines de Big Data basados en ELT para iniciativas de aprendizaje automático utilizando lagos de datos.

- Las empresas pueden utilizar programadores de flujo de trabajo por lotes para declarar programáticamente flujos de trabajo como tareas con dependencias y automatizar estas operaciones.

- Software de streaming de datos en tiempo real procesa datos continuamente generados por fuentes como sensores mecánicos, dispositivos IoT e Internet de las cosas médicas (IoMT), o sistemas de transacciones.

- Herramientas de Big Data incluyen soluciones de streaming de datos y otras tecnologías que permiten el flujo de datos de extremo a extremo.

Datos detallados profundizan profundamente

En el pasado, volúmenes de datos de diversas fuentes se almacenaban en silos separados que no podían ser accedidos, entendidos o analizados en ruta. Para empeorar las cosas, los datos estaban lejos de ser en tiempo real.

¿Pero hoy? A medida que la cantidad de fuentes de datos crece, la velocidad a la que la información atraviesa organizaciones y sectores enteros es más rápida que nunca. Los pipelines de datos son el esqueleto de los sistemas digitales. Transfieren, transforman y almacenan datos, brindando a empresas como la tuya ideas significativas. Sin embargo, los pipelines de datos deben actualizarse para igualar el ritmo con la creciente complejidad y número de conjuntos de datos.

La modernización requiere tiempo y esfuerzo, pero los pipelines de datos eficientes y contemporáneos te empoderarán a ti y a tus equipos para tomar decisiones mejores y más rápidas, dándote una ventaja competitiva.

¿Quieres aprender más sobre la gestión de datos? ¡Aprende cómo puedes comprar y vender datos de terceros!

Samudyata Bhat

Samudyata Bhat is a Content Marketing Specialist at G2. With a Master's degree in digital marketing, she currently specializes her content around SaaS, hybrid cloud, network management, and IT infrastructure. She aspires to connect with present-day trends through data-driven analysis and experimentation and create effective and meaningful content. In her spare time, she can be found exploring unique cafes and trying different types of coffee.