Das Konzept des Cloud-Computing ist nicht neu. Verweise auf Cloud-Computing gibt es seit den 1960er Jahren, obwohl damals „Cloud“ noch nicht Teil des Lexikons war. Damals wurde die Nutzung von Remote-Computing- und Verarbeitungselementen als „netzwerkbasiert“ bezeichnet.

Angesichts der Tatsache, dass mehrere Unternehmensanbieter – Amazon, Google, Microsoft und IBM – Mitte der 2000er Jahre die Idee aufgriffen, Remote-Server als Mittel zur Steigerung der Rechenkapazität zu nutzen, ist es nicht verwunderlich, dass ihnen die moderne Entwicklung der Cloud zugeschrieben wird. Amazons Elastic Compute Cloud wurde 2006 eingeführt; IBMs Cluster-Computing, in Zusammenarbeit mit Google, kam 2007; Microsofts Azure kam 2010; Googles Compute Engine erschien 2012.

Software-as-a-Service (SaaS)-Angebote, wie die CRM-Plattform von Salesforce, trugen dazu bei, die Einführung von Cloud-Computing in jeder Branche und in jeder Hinsicht zu beschleunigen. SaaS öffnete die Welt für die Cloud und ihre Fähigkeit, Kosten durch nutzungsbasierte Käufe zu senken, während sie dennoch eine Leistung bietet, die gleichwertig oder besser ist als On-Premises-Optionen.

Warum Unternehmen die Cloud übernommen haben

Kosteneinsparungen sprechen für sich selbst für die Einführung der Cloud. Vor der Cloud waren die Kosten hoch und lagen im Bereich der CapEx (Investitionsausgaben), große Vorauszahlungen für Software, Server oder andere physische Infrastruktur. Cloud-Computing verlagert viele dieser CapEx-Kosten in OpEx (Betriebsausgaben) oder kleinere, nutzungsabhängige Kosten. Wie? Nutzungsskalierbarkeit.

Das größte Problem bei CapEx ist, dass Unternehmen am Ende zu viel kaufen können. Beim Cloud-Computing zahlen die Nutzer für das, was sie tatsächlich nutzen. Eine Cloud-Lösung, für die Sie vier Lizenzen benötigen? In Ordnung, zahlen Sie für vier. Jetzt brauchen Sie neun? Zahlen Sie für neun.

Diese Art von Skalierbarkeit ist in allen Marktsegmenten von Vorteil. Kleine Unternehmen – die oft die engsten Budgets haben – zahlen für das, was sie brauchen, und nicht mehr. Diese Cloud-Struktur senkt die Eintrittsbarrieren für kleine Unternehmen erheblich. Unternehmen, die ihre Abläufe optimieren und Kosten senken möchten, verlassen sich auf die Cloud, um während Wachstums- und Wartungsphasen mit ihnen zu skalieren. Insbesondere wenn es um Infrastruktur geht, können Unternehmen mehr bezahlen, wenn sie mehr benötigen, und weniger bezahlen, wenn weniger erforderlich ist. Diese elastische Kapazität ermöglicht es beispielsweise E-Commerce-Anbietern, ihren Serverplatz am Cyber Monday zu erweitern, wenn sie einen massiven Anstieg des Webverkehrs verzeichnen.

Flexibilität ergibt sich nicht nur aus der Skalierung. Da Cloud-Dienste und -Infrastrukturen alle remote zugänglich sind, erhöht sich die Kapazität für grenzüberschreitende Geschäftsmodelle. Mitarbeiter in Bangalore, London, Chicago und San Francisco können alle an denselben Projekten arbeiten und auf dieselben Daten zugreifen. Oder ein Unternehmen könnte ein kleines Büro nutzen, indem es Mitarbeiter dank der Zugänglichkeit von Cloud-Daten remote arbeiten lässt. Die Geschäftswelt nimmt dies heutzutage als selbstverständlich hin, aber es kann nicht genug betont werden, wie entscheidend wichtig der Fernzugriff ist. Die Produktivität des modernen Unternehmens und die Fähigkeit, Dienstleistungen über Ländergrenzen hinweg und international anzubieten, würden ohne diese Schlüsselkompetenz zum Erliegen kommen.

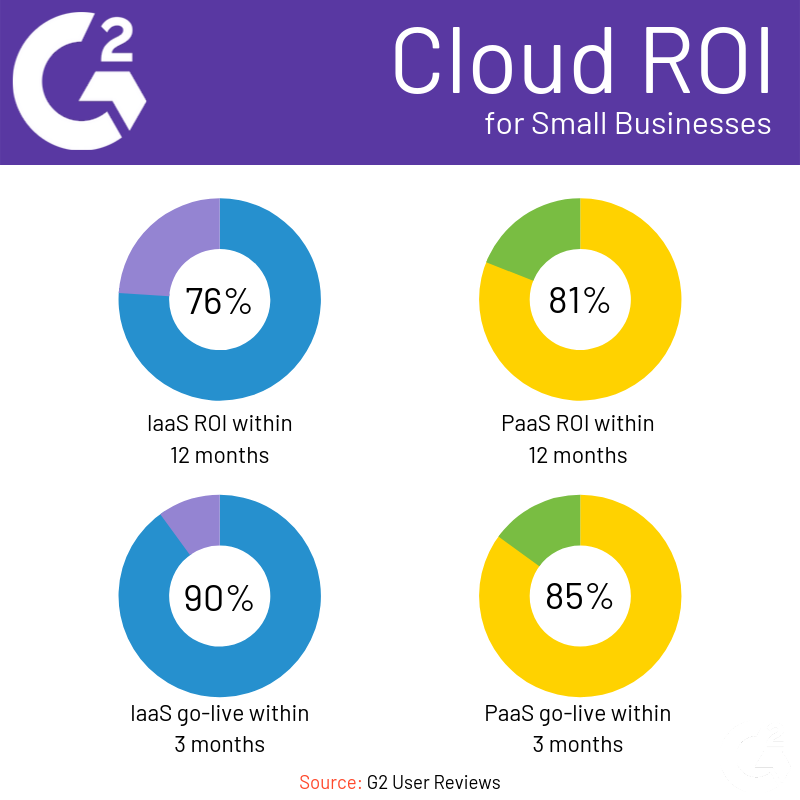

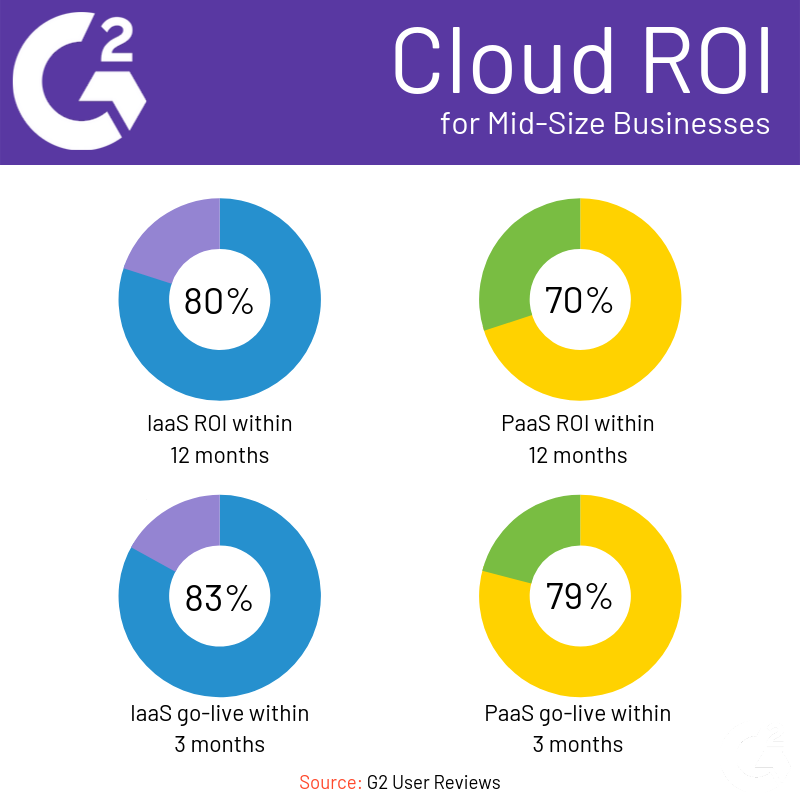

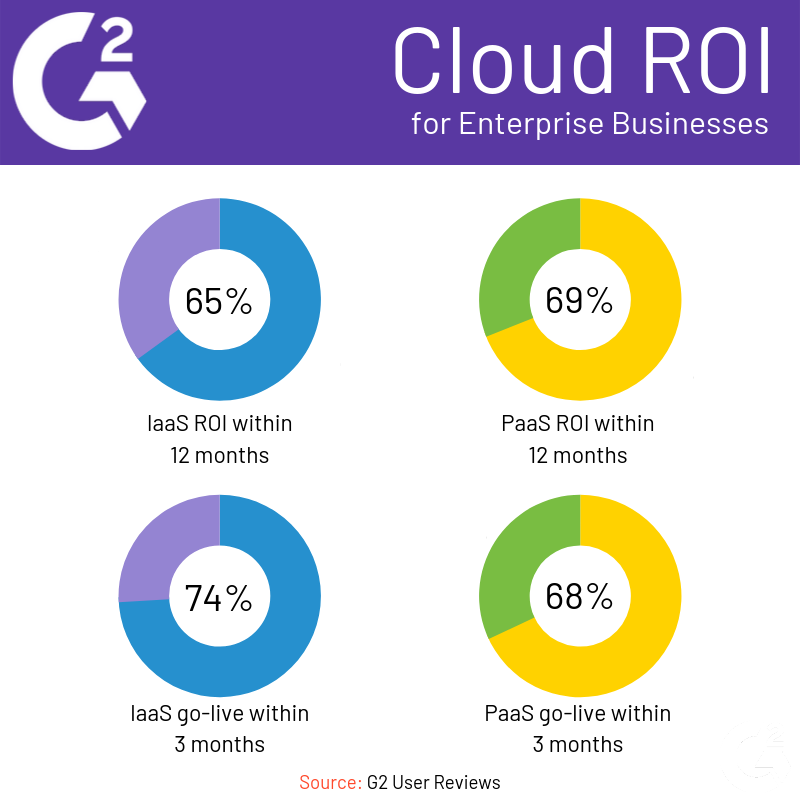

Wir haben einige G2-Benutzerbewertungen zusammengestellt, um herauszufinden, wie Unternehmen unterschiedlicher Größe die Cloud übernommen haben. Sie können unten eine Aufschlüsselung für kleine Unternehmen, mittelständische Unternehmen und Großunternehmen sehen.

Möchten Sie mehr über Virtuelle Desktop-Infrastruktur (VDI) Software erfahren? Erkunden Sie Virtuelle Desktop-Infrastruktur (VDI) Produkte.

Cloud-Entwicklung

Seit der Einführung des Cloud-Computing haben sich drei „Klassen“ des Cloud-Computing herausgebildet.

- Öffentliches Cloud-Computing Ressourcen sind öffentlich auf Abonnement- oder Pay-as-you-go-Basis verfügbar und nehmen oft die Form von Speicher oder virtueller Infrastruktur an (z. B. VDI). Öffentliche Cloud-Ressourcen werden vom Anbieter verwaltet, wodurch routinemäßige Infrastrukturaufgaben aus den Arbeitslasten der Benutzer entfernt werden. Stattdessen können sich die Benutzer anspruchsvolleren, anspruchsvolleren Aufgaben widmen.

- Private Cloud-Computing bietet gleichwertige oder bessere Leistung und Fähigkeiten als öffentliche und bietet mehr Kontrolle und Anpassungsmöglichkeiten, die Sie von On-Premises-Lösungen erwarten könnten. Mit größerer Kontrolle über dedizierte Ressourcen und Sicherheit müssen Unternehmen, die private Cloud-Ressourcen nutzen, einen Teil ihrer eigenen Ressourcen für Wartung und Pflege aufwenden.

- Hybrides Cloud-Computing mischt On-Premises- und öffentliche oder private Cloud-Ressourcen. Dies werden Sie wahrscheinlich sehen, wenn Unternehmen anspruchsvollere, sicherheitsrelevante oder compliance-bezogene Ressourcen vor Ort behalten möchten (z. B. medizinische PII), aber nichts dagegen haben, andere weniger kritische Ressourcen in einer öffentlichen oder privaten Cloud laufen zu lassen (z. B. ein Patientenportal).

Mit der zunehmenden Verfügbarkeit von Cloud-Ressourcen ist die Idee der Multicloud entstanden. Ein Multicloud-Setup bedeutet, dass Unternehmen in mehrere Cloud-Ressourcen und -Anbieter investieren und jeden für einen bestimmten Funktionssatz nutzen. Beispielsweise könnte ein Unternehmen eine Cloud speziell für die Containerisierung nutzen, während es eine andere für Datenbanken und Speicher verwendet. Ein Unternehmen könnte einen Cloud-Anbieter für IaaS, einen anderen für PaaS und eine Vielzahl für SaaS nutzen. Der Multicloud-Ansatz ermöglicht es Unternehmen, die größten Stärken jedes Cloud-Anbieters zu nutzen und in Best-of-Breed für jede benötigte Geschäftsanforderung zu investieren. Dies optimiert die Gesamtleistung eines Unternehmens. Multicloud mindert auch einige der Risiken, die mit der Abhängigkeit von einem einzigen Anbieter verbunden sind (z. B. technische Abhängigkeit von einem Anbieter, der 100 % Betriebszeit hat).

Zukünftige Überlegungen zu Cloud-Ressourcen

Aufgrund der weitreichenden Konsequenzen in einem Unternehmen oder auf dem Markt insgesamt ist es wichtig, einige Schlüsselbereiche zu beobachten, während das Cloud-Computing in Verfügbarkeit und Nutzung expandiert.

Failover und Wiederherstellung

Ein Teil der Investition in Cloud-Ressourcen besteht darin, dass Sie deren Betriebszeit und Ausfallzeit ausgeliefert sind. Unerwartete Ausfälle – insbesondere während der Spitzenzeiten – können kostspielig sein, selbst wenn sie nur wenige Minuten dauern. Viele Cloud-Anbieter bieten Failover-Funktionen oder ein gewisses Maß an Redundanz/Wiederherstellung als Verkaufsargument, um Ausfälle zu mindern. Da jedoch im Laufe der Zeit immer mehr Ressourcen in die Cloud verlagert werden, werden Backups, Redundanzen und DRaaS zu Mindestanforderungen an Cloud-Anbieter. Die Konsolidierung dieser Fähigkeiten mit bestehenden Cloud-Ressourcen wird die Verbraucherfrustration verringern und die Kundenbindung für Cloud-Anbieter erhöhen.

Cloud-Sicherheit

Die Sicherung von Cloud-Ressourcen stellt für viele Unternehmen eigene Herausforderungen dar. Ich habe Aaron Walker, unseren Forschungsanalysten, der sich auf Sicherheit spezialisiert hat, nach seiner Meinung gefragt. Er identifiziert drei große Herausforderungen, denen Unternehmen bei der Sicherung ihrer Cloud-Ressourcen gegenüberstehen: Identitätsmanagement, Datenmanagement und Verschlüsselung sowie Fachkräftemangel.

"Identitätsmanagement ist sehr wichtig und eine der einfachsten Bedrohungen für Daten, die behoben werden können, obwohl es mühsam sein kann, es zu verwalten und zu pflegen. Rollenbasierte Identitäten sollten eingerichtet und erforderlich sein, um administrative Aktionen durchzuführen. Multi-Faktor-Authentifizierung und risikobasierte Authentifizierungstools sollten erforderlich sein, um auf jegliche Art von sensiblen Informationen zuzugreifen.

Datenmanagement und Verschlüsselung sind die nächsten Schutzschichten. Alle ruhenden sensiblen Informationen sollten verschlüsselt werden. Datenzentrierte Sicherheitstools sind nützlich, um Informationen zu entdecken und zu organisieren, die verschlüsselt werden müssen. Sie können auch dabei helfen, Daten zu verwalten und zu clustern, um Richtlinien gemäß ihren Labels, Eigenschaften und Anforderungen durchzusetzen.

Schließlich gibt es einen Mangel an qualifizierten Cybersicherheitsfachleuten, und da Cloud-Sicherheit einer der neuesten und sich am schnellsten entwickelnden Sicherheitsmärkte ist, sind Cloud-Sicherheitsfachleute rar gesät. Unerfahrene Sicherheitsexperten sind eher dazu geneigt, Richtlinien falsch zu konfigurieren und Identitäten falsch zu verwalten."

Die Verantwortung für die Sicherung von Cloud-Ressourcen liegt bei den Unternehmen, nicht bei den Anbietern. Walker stellt fest, dass – insbesondere im Falle von Datenverletzungen – Anbieter dazu neigen, die Verantwortung auf die Unternehmen selbst abzuwälzen. Unternehmen, die Cloud-Ressourcen nutzen, müssen daher wachsam sein, um das, was sie nutzen, zu sichern. Um Cloud-Sicherheitsrisiken zu mindern, weist Walker darauf hin, dass Unternehmen sicherstellen, dass Webanwendungs-Firewalls (WAFs) gut konfiguriert sind; Netzwerksicherheitsrichtlinien-Management (NSPM)-Tools helfen dabei.

Die neuen Monopole?

Wie bei den meisten neuen Dingen in der Technologiewelt sind die Organisationen, die die Führung übernehmen, in der Regel diejenigen mit den meisten verfügbaren Mitteln. Es ist nicht überraschend, Anbieter wie AWS, Microsoft und Google zu sehen, die den Cloud-Computing-Markt dominieren. Wenn sich die Märkte jedoch entwickeln, vertieft sich das Feld der Anbieter, und was zuvor ein Monopol oder Duopol war, wird wettbewerbsfähig.

Eine gesunde Branche erfordert, dass die Cloud-Giganten ihren Griff lockern. Allein im öffentlichen Cloud-Bereich werden nur 16 % aller öffentlichen Clouds nicht von AWS, Azure, Google oder Alibaba gehostet. AWS allein hostet fast 50 % der öffentlichen Cloud, und zusammen mit Azure nehmen sie etwa 70 % des öffentlichen Cloud-Marktes ein. Das ist eine ganze Menge Daten an nur zwei Orten. Die Konsolidierung so vieler öffentlicher Cloud-Daten – oder sogar so viel des Marktes – in einem oder zwei Unternehmen bedeutet Ärger. Es wird wahrscheinlich der Datenbesitz sein, der die Überarbeitung der Antitrust-/Monopolisierungsgesetze vorantreibt, eher früher als später.

In der Zwischenzeit müssen Unternehmen, die aus dem Löwenanteil von Amazon und Azure schöpfen möchten, sie auf ihrem eigenen Spielfeld schlagen, jedoch auf Markt- oder Branchenebene. Sie müssen sich spezialisieren. Wir werden wahrscheinlich eine Welle neuer Cloud-Anbieter sehen, die sich beispielsweise speziell an kleine Unternehmen oder Gesundheitsdienstleister richten und Cloud-Infrastruktur oder -Dienste speziell für deren Bedürfnisse entwerfen.

Halten Sie Ausschau nach G2-Forschern auf Technologiemessen später in diesem Jahr, darunter AWS re:Invent und Dreamforce. In der Zwischenzeit erfahren Sie mehr über unsere Forscher und was wir tun.

Zack Busch

Zack is a former G2 senior research analyst for IT and development software. He leveraged years of national and international vendor relations experience, working with software vendors of all markets and regions to improve product and market representation on G2, as well as built better cross-company relationships. Using authenticated review data, he analyzed product and competitor data to find trends in buyer/user preferences around software implementation, support, and functionality. This data enabled thought leadership initiatives around topics such as cloud infrastructure, monitoring, backup, and ITSM.