Sprachtechnologie: Die Stimme, die um die Welt gehört wird. Wir alle haben von Amazons Alexa und Google Assistant gehört (vielleicht sogar von Samsungs Bixby und Alibabas Tmall Genie).

Wie ich in meiner letzten monatlichen Kolumne erwähnt habe, ist eine der aufregenden neuen Grenzen der Technologie die sich verändernden Wege, wie wir mit ihr interagieren. Insbesondere die Sprachtechnologie hat eine große Rolle bei diesen Veränderungen gespielt. Willkommen im multimodalen Zeitalter, in dem Sprachtechnologie und Natural Language Processing (NLP) die Oberhand haben.

Der Aufstieg der Sprachtechnologie

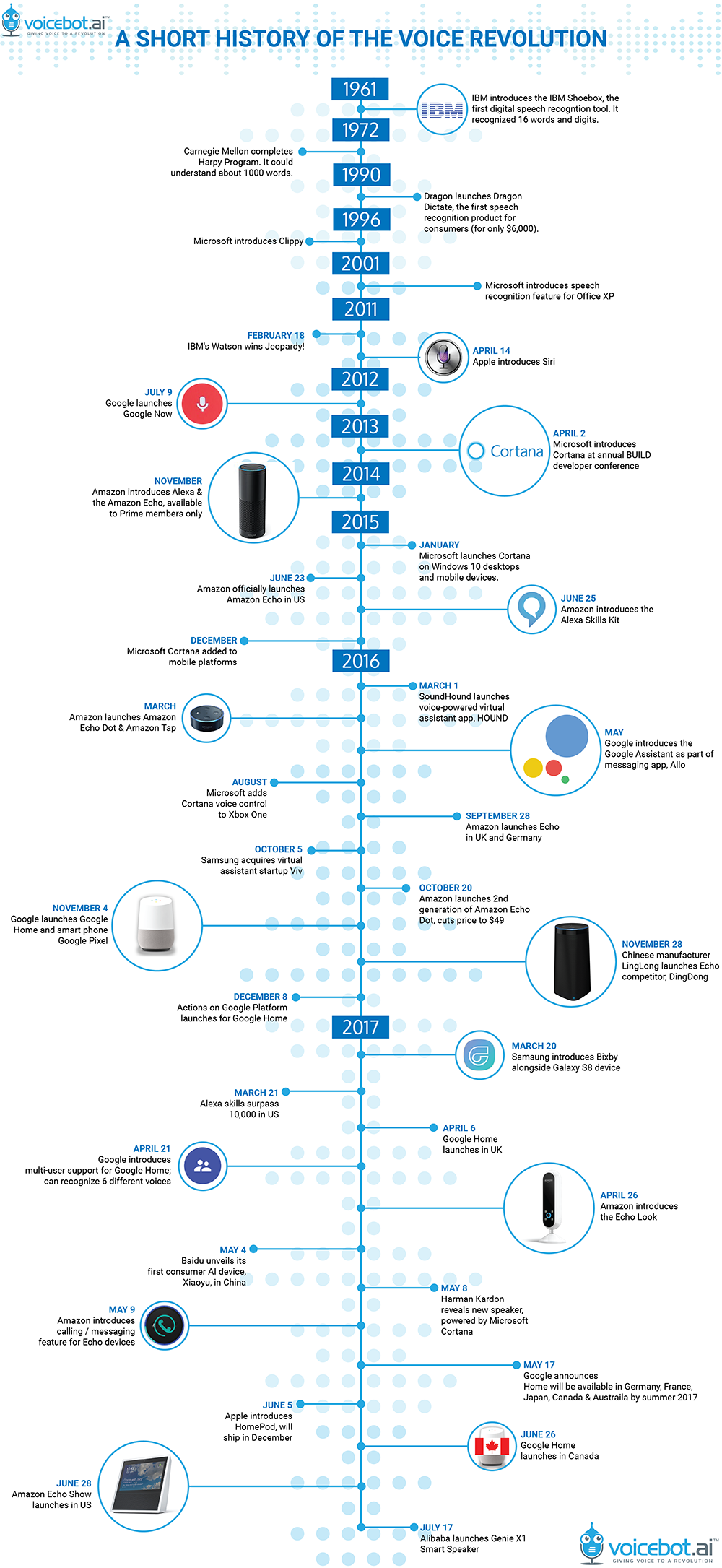

Sprachtechnologie oder Spracherkennung, zusammen mit dem Internet der Dinge (IoT), ist so allgegenwärtig, dass wir dazu neigen zu vergessen, dass sie nicht immer Teil unseres Lebens war.

| VERWANDT: Erfahren Sie mehr über die Funktionsweise der Spracherkennung. |

Quelle: voicebot.ai

Quelle: voicebot.ai

Sprachassistenten verschwinden nicht. Im Gegenteil, sie scheinen jeden Tag mehr Anwendungsfälle zu haben. Wie sieht die Akzeptanz dieser Sprachassistenten in der Praxis aus? Wie wird die Technologie genutzt und wie nutzen Unternehmen sie, um Nutzer oder potenzielle Kunden zu erreichen?

Eines ist sicher: Die Stimme ist im Aufstieg. Im ersten Quartal 2019 besaßen über 31 % der Haushalte in den Vereinigten Staaten einen Smart Speaker mit einem intelligenten persönlichen Assistenten. (Vergleichen Sie das mit den 8 %, die 2016 einen besaßen.) Das Vereinigte Königreich ist nicht weit dahinter. Neue Daten von Strategy Analytics zeigten, dass bis Juni 2019 etwa 20 % der Haushalte im Vereinigten Königreich einen Smart Speaker haben.

Der Besitz von Smart Speakern ist nur ein Teilindikator für die Verbreitung der Sprachtechnologie. Einschließlich der Nutzung von Mobiltelefonen hat Location World herausgefunden, dass etwa 40 % der Erwachsenen mindestens einmal am Tag die Sprachsuche nutzen.

| VERWANDT: Schauen Sie sich diese 43 Sprachsuchstatistiken für 2019 → |

Laut eMarketer werden 31 Millionen Amerikaner in diesem Jahr über einen Smart Speaker einkaufen. Da Kunden die Möglichkeit haben, Lebensmittel über Google Assistant zu bestellen und so gut wie alles über Amazon über Alexa, ist es wahrscheinlich, dass mehr Kunden in naher Zukunft Sprachtechnologie nutzen werden. Aus geschäftlicher Sicht ist die Möglichkeit, den Umsatz durch Sprachtechnologie zu steigern, aufregend.

Das Fazit: Die Stimme verbreitet sich, daher müssen Marken sie nutzen und als Teil ihrer umfassenderen digitalen Strategie einbeziehen. Im Folgenden konzentrieren wir uns auf den E-Commerce-Bereich, werden aber in späteren Kolumnen andere weitreichende Branchenanwendungen erkunden.

Warum passiert das?

Um zu verstehen, warum Sprachtechnologie so schnell angenommen wurde, lohnt es sich, einen Blick auf die Entwicklung der Mensch-Computer-Beziehung zu werfen, die sich in der Technologie selbst entwickelt hat, sowie auf die Benutzererfahrung (UX).

Viele komplexe Technologien wie AR, VR, IoT und Gestensteuerung greifen das Bedürfnis nach natürlichen Benutzeroberflächen auf. Wir sind schon lange auf dem Weg zu dieser Naturalisierung der Mensch-Computer-Beziehung.

Wir bewegen uns in Richtung benutzerfreundlicherer, intuitiverer Schnittstellen. Ob mit Schaltern, Tastaturen oder Touchscreens, wir kommunizieren mit unserer Technologie auf natürlichere Weise. Die Stimme, ermöglicht durch Spracherkennungstechnologie (wie die von Google mit 95 % Genauigkeit), ist die nächste Grenze.

Gleichzeitig haben sich die Kriterien für die Benutzererfahrung weiterentwickelt. Bei der Entwicklung von Technologien konzentrierten sich Entwickler früher auf Kriterien wie Zuverlässigkeit, Genauigkeit und Geschwindigkeit. Heute sprechen wir über Technologien, denen wir vertrauen können, mit denen wir Beziehungen aufbauen und in denen wir Komfort finden. Diese Entwicklung in der Personalisierung der Technologie ist der Schlüssel zur neuen Form der Benutzererfahrung. Es ist wichtig zu beachten, dass frühere Erwartungen nicht verschwunden sind. Wir erwarten immer noch, dass unsere Technologie schnell und zuverlässig ist; wir wollen jetzt, dass sie das auf eine Weise tut, die sich sowohl organisch als auch maßgeschneidert anfühlt – es wird schließlich Natural Language Processing (NLP) genannt.

Die Stimme lässt Technologie menschlicher wirken und ermöglicht es den Menschen, ihr mehr zu vertrauen. Die Stimme wird sich als wichtige natürliche Schnittstelle erweisen, die unsere Kommunikation und Beziehungen mit unseren Geräten vermittelt und letztendlich unsere Kommunikation und Beziehungen in einer KI-gesteuerten Welt.

Natürlich sprechen mit Sprachtechnologie

Was sind die Merkmale der Stimme, die sie zu einer so natürlichen Schnittstelle machen?

-

- Geschwindigkeit: Homo sapiens sprechen durchschnittlich 150 Wörter pro Minute und tippen durchschnittlich 40 Wörter pro Minute. Wenn wir sprechen, gibt es keinen Prozess, der die Stimme in unserem Kopf in referenzielle Tasten auf einer Tastatur oder einem Telefon übersetzt.

- Befreiend: In einer Welt, in der Technologie uns befreien soll, haben uns die Entwicklung von Bildschirmen auf Telefonen und Tablets eingeschränkt und gezwungen, den Kopf nach unten zu neigen. Die Stimme bringt unseren Kopf wieder nach oben, befreit uns von der Fixierung auf einen Bildschirm und ermöglicht die Fähigkeit, Multitasking zu betreiben und gleichzeitig mit unseren Technologien zu interagieren. Mit der Stimme können wir nahtlos Multitasking betreiben, da sie bereits ein natürlicher Teil unserer Umgebung ist.

- Ursprünglich: Wir können sprechen, solange wir uns erinnern können. Die Stimme wird in den primitivsten Teilen unseres Gehirns registriert; daher ist die Stimme im Vergleich zu anderen Kommunikationsformen nicht so belastend für unser Gehirn.

Die Interaktionen von Individuen mit Computern, Fernsehen und neuen Medien sind laut "The Media Equation" von Reeves und Nass grundsätzlich sozial und natürlich, genau wie Interaktionen im wirklichen Leben.

Möchten Sie mehr über Spracherkennungssoftware erfahren? Erkunden Sie Spracherkennung Produkte.

Welchen Wert bietet die Stimme für Marken?

Wie können Marken diese neue Schnittstelle zu ihrem Vorteil nutzen? Es gibt mehrere Aspekte der Stimme, die Unternehmen berücksichtigen sollten, wenn sie ihre Sprachreise beginnen.

-

Eine digitale Persönlichkeit schaffen

Sprachtechnologie gibt Marken die Möglichkeit, ihren einzigartigen Klang zu entdecken und eine digitale Persönlichkeit zu entwickeln, um bedeutungsvolle und flüssige Markenerlebnisse zu schaffen, die Markentreue bei ihren Kunden fördern. Zum Beispiel hat Just Eat, ein britischer Online-Lieferdienst für Lebensmittelbestellungen, dies gut mit humorvollen Antworten wie „You’ve ordered like a bawse (boss)!“ und „Okie dokie buddy“ gemacht. Auch wenn das ziemlich einfach erscheinen mag, kann es viel dazu beitragen, die Interaktion eines Kunden mit dieser Marke zu humanisieren. -

Bewusstsein schaffen

Marken können die Stimme nutzen, um ihre Auffindbarkeit zu erhöhen und Markenbewusstsein zu schaffen, indem sie ein Spracherlebnis entwerfen, das Nutzen bietet. Zum Beispiel hat Tide eine Sprach-App auf Alexa entwickelt, mit der Benutzer sprechen können, um Hilfe beim Entfernen verschiedener Fleckenarten zu erhalten. Die Nutzung von Sprachtechnologie, um den Verbrauchern Nutzen zu bieten, hilft Tide, eine Assoziation zwischen seiner Marke und seinen Produktzielen (schnelle Fleckenentfernung) zu verankern. -

Transaktionen erleichtern

Eine Marke, die ein Spracherlebnis entwickelt, das den Kaufprozess erleichtert, wird ein Kauferlebnis bieten, das die Reibung für den Benutzer reduziert und zu Kundenloyalität führt. Ein großartiges Beispiel ist die Ocado Alexa-Fähigkeit. Diese Fähigkeit unterstützt beim Kauf von Lebensmitteln und bietet den Benutzern ein fantastisches Sprachtechnologie-Erlebnis. Domino’s ist ein weiteres großartiges Beispiel, das Kunden eine Amazon Alexa-Fähigkeit bietet, die es einfach macht, schnell Pizza zu bestellen. -

Die Interaktion personalisieren

Marken können Sprachinteraktionen auf die Bedürfnisse und Wünsche ihrer Verbraucher zuschneiden, um einen Vertrauenshalo zu entwickeln. Zum Beispiel hat American Express eine Alexa-Fähigkeit, die Daten und Informationen bereitstellt, wie z. B. Ausgabemuster, die auf den jeweiligen Kunden zugeschnitten sind.

| VERWANDT: Erfahren Sie vier Möglichkeiten, um auf die Stimme des Kunden zu hören und die Kundenerfahrung zu verbessern, hier → |

Und jetzt?

Soweit wir gesehen haben, erwarten Endbenutzer, dass Marken über Sprachtechnologie verfügbar sind. Mit dieser Realität im Hinterkopf müssen SaaS-Unternehmen die Lücke schließen und den Benutzern Werkzeuge zur Verfügung stellen, um erfolgreich zu sein.

Einige Trends, die wir kürzlich in diese Richtung gesehen haben, sind:

- Sprachsuche als Dienstleistung: Algolia, das letzten Monat 110 Millionen Dollar gesammelt hat, möchte einen großen Vorstoß in Richtung Stimme machen. Sowohl der CEO als auch der Mitbegründer sagten, das Unternehmen wolle „[seine] konversationellen und Sprachsuchfähigkeiten über Web-, Mobil- und Sprachkanäle hinweg bereichern, um der steigenden Verbrauchernachfrage gerecht zu werden, auf jede Weise, überall und jederzeit zu suchen.“

- Drag-and-Drop-Tools zum Erstellen von Sprach-Apps: Im April hat Voiceflow, das es jedem ermöglicht, Sprach-Apps ohne Programmierung zu erstellen, 3,5 Millionen Dollar gesammelt.

-

- Sprachfähige Websites: Ende Juli hat Airbud 4 Millionen Dollar gesammelt. Diese Technologie wird es Benutzern ermöglichen, einfach eine Sprachschnittstelle zu ihrer Website hinzuzufügen.

Über diese Einschränkungen sprechen

Obwohl das Bild, das wir gemalt haben, genau ist, sind die Pinselstriche breit und die Farbe ist begrenzt.

Im zweiten Teil dieser Serie werden wir uns die Einschränkungen der Sprachtechnologie in verschiedenen Branchen ansehen, einschließlich Datenschutz-Bedenken, die Zukunft des Sprach-Handels und mehr.

Bleiben Sie dran.

Matthew Miller

Matthew Miller is a research and data enthusiast with a knack for understanding and conveying market trends effectively. With experience in journalism, education, and AI, he has honed his skills in various industries. Currently a Senior Research Analyst at G2, Matthew focuses on AI, automation, and analytics, providing insights and conducting research for vendors in these fields. He has a strong background in linguistics, having worked as a Hebrew and Yiddish Translator and an Expert Hebrew Linguist, and has co-founded VAICE, a non-profit voice tech consultancy firm.